Viviamo in un mondo pieno di dati. Dalla possibilità di elaborarli digitalmente dipende anche la capacità di trovare soluzioni ai problemi che la realtà ci pone in modo sempre più complesso. È il cosiddetto machine learning o apprendimento automatico.

Gli studiosi sono concordi nel ritenere che i computer che funzionano in base ai principi della quantistica potranno fornire un grande aiuto in questo senso, perché dispongono di una potenza e di una velocità di calcolo attualmente inimmaginabili. Ma come classificare i Big Data in ambito quantistico, come suddividerli in categorie separate, tenuto conto che i dati non sono necessariamente rappresentati geometricamente e la loro distribuzione nell’insieme originale può essere piuttosto irregolare?

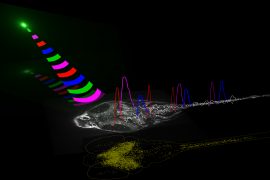

Alcuni scienziati avevano già ipotizzato di utilizzare un computer quantistico per mappare (cioè incorporare) i dati in uno spazio di dimensioni superiori (“spazio di Hilbert”) in cui fosse più facile separare le classi di oggetti. Ma la prima prova sperimentale dell’embedding quantistico (mappatura quantistica dei dati) arriva da una ricerca pubblicata su Advanced Quantum Technologies, sotto la guida di Filippo Caruso, docente di Fisica della Materia presso il Dipartimento di Fisica e Astronomia dell’Università di Firenze e attivo presso il Laboratorio Europeo di Spettroscopia Non lineare (Lens) [“Experimental Quantum Embedding for Machine Learning” doi: 10.1002/qute.202100140 ]. Il team Unifi-Lens è stato affiancato nella ricerca dall’Università di Roma Tre e dall’Istituto Nazionale di Ottica del Consiglio Nazionale delle Ricerche (Cnr-Ino).

La mappatura dei dati è stata realizzata su due diversi sistemi quantistici sperimentali ingegnerizzati e i risultati sono stati confrontati con quelli ottenuti utilizzando un computer quantistico disponibile su cloud. I dati sono stati ottimizzati su un computer classico e poi implementati su piattaforme quantistiche, che erano basate su diverse realizzazioni fisiche di qubit – l’unità d’informazione dei computer quantistici: fotoni, atomi freddi e superconduttori.

“Lo studio –afferma Filippo Caruso – ha mostrato che tutte le architetture, basate su principi fisici molto diversi, hanno effettivamente dato risultati soddisfacenti nella realizzazione della mappatura quantistica: un risultato promettente per i sistemi futuri basati su architetture ibride con hardware specializzato per l’archiviazione, l’elaborazione e la distribuzione di dati quantistici”.

“Il nostro studio, che ha meritato la front cover della rivista scientifica – conclude Caruso –, segnala non solo la possibilità di semplificare un problema di classificazione, ma anche la capacità di velocizzare notevolmente qualsiasi elaborazione dei dati classici, come la ricerca attraverso un database, l’estrazione di caratteristiche, la segmentazione di immagini e molti altri in vari ambiti, dalla sociologia all’economia, dalla geografia alla biomedicina. In una parola, le tecnologie quantistiche potrebbero rappresentare il futuro per risolvere i problemi del mondo reale”.